NIPS2017 気になった論文10本まとめてみる

こんにちは@shunk031です。好きな食べ物はニューラルネットワークです。 Advent Calendarの季節に乗じてブログを更新してみようと思います。

機械学習のトップカンファレンスであるNIPS2017が12月4日から9日にかけてアメリカのロングビーチにて行われます。先日NIPS2017のProceedingsが公開され、Acceptされた論文が読めるようになっています。

今回個人的に気になった論文10本について、ざっくりとした内容を載せたいと思います。Acceptされた多数の論文の中で詳細に読むものを選ぶ基準として使ってもらえたりしたら幸いです。

目次

- 目次

- Regularizing Deep Neural Networks by Noise: Its Interpretation and Optimization

- DropoutNet: Addressing Cold Start in Recommender Systems

- Sparse Embedded k-Means Clustering

- SVD-Softmax: Fast Softmax Approximation on Large Vocabulary Neural Networks

- Few-Shot Adversarial Domain Adaptation

- Dilated Recurrent Neural Networks

- Deep Subspace Clustering Networks

- Variable Importance Using Decision Trees

- Deanonymization in the Bitcoin P2P Network

- Unsupervised Learning of Disentangled and Interpretable Representations from Sequential Data

- まとめ

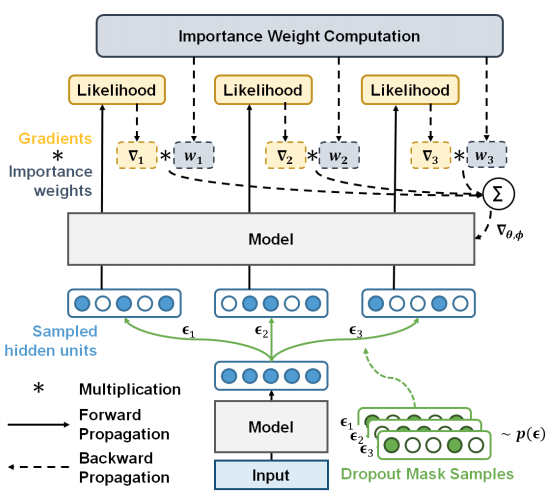

Regularizing Deep Neural Networks by Noise: Its Interpretation and Optimization

- Hyeonwoo Noh, Tackgeun You, Jonghwan Mun, Bohyung Han (Poster)

過学習はDeep neural networkの学習における課題の1つであり、汎化性能を向上させるためにさまざまな正則化手法が提案されてきた。中でも学習中にHidden unitに対してノイズを乗せるDropoutは有名な正則化手法として知られているが、こうした正則化手法がなぜ効果があるのかは不明である。

本研究では従来のノイズ付加による正則化手法が真の目的関数の下限に対して最適化すること、Stochastic gradient descentにおいて、より制約の強い下限にフィットするよう複数のノイズを導入する手法を提案している。CIFAR10等のデータセットを用いて提案手法の効果を確かめている。

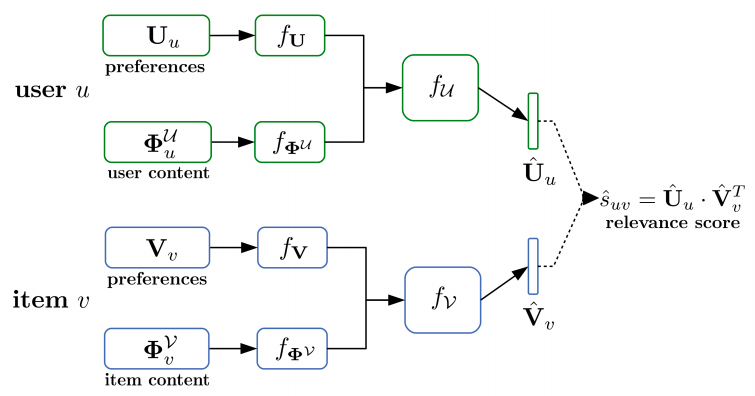

DropoutNet: Addressing Cold Start in Recommender Systems

- Maksims Volkovs, Guangwei Yu, Tomi Poutanen (Poster)

潜在的な意味を捉えるモデルは、精度の良さやスケーラビリティを有するため、レコメンドシステムを導入する際にデフォルトの選択肢の1つとなっている。しかしながらレコメンドといった分野の先行研究では、主にユーザーとアイテムの関係をモデル化したものが多く、データが少ない場合に起こる「コールドスタート問題」に対する解決策を提示しているモデルは少ない。Deep learningは近年様々な入力に対して優れた成功を収めている。そういったモデルを利用し、レコメンドシステムにおけるコールドスタート問題を解決するため、ニューラルネットワークベースのDropoutNetを提案している。

コンテンツベースの目的関数を追加した既存の手法と異なり、本研究では最適化手法に焦点を当てたのと、Dropoutを応用して明示的にコールドスタートに対してモデルのトレーニングを行う方法を示している。提案モデルは既存のモデルに対して適用することができ、コールドスタートに対して効果を発揮している。コールドスタート問題を解決しているかを評価できるCiteULikeデータセットやACM RecSys 2017 challengeデータセットを用いて、提案モデルが優れた結果を出していることを確認している。

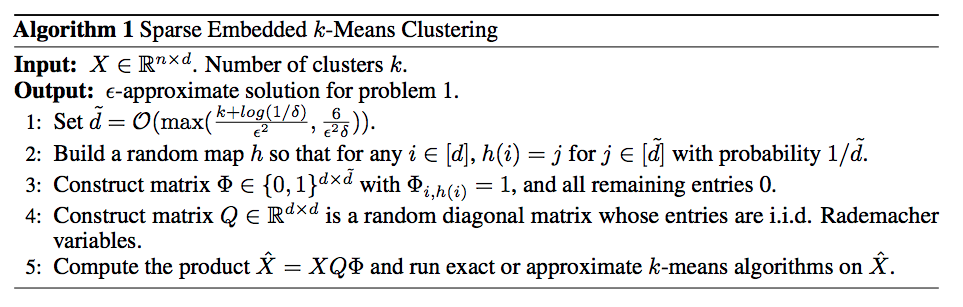

Sparse Embedded k-Means Clustering

- Weiwei Liu, Xiaobo Shen, Ivor Tsang (Poster)

K-meansクラスタリングは広く知られている素晴らしいアルゴリズムであるが、高次元のデータに対しては、計算コストの高さゆえに様々な分野への応用を妨げている現状がある。一般的には次元削減の手法を用いて対処することが多いが、近年Random projection(RP)などの手法を用いて高速なK-meansクラスタリングを実現することができる。しかしながらこの手法は他の次元削減手法よりも多くの改善点が存在している。例として特異値分解(SVD)に基づく特徴抽出手法と比較して、RPは近似を行いつつ、データ数で特徴数

のデータ

に対して

だけ実行時間を削減している。

これらの改善を経てもなお行列の乗算にはだけ必要であり、特にデータ数

や特徴数

が大きい場合にはとても大きな計算コストとなってしまう。これらのボトルネックを解消するため、本研究では

(

は

内における非ゼロの数を表している)を必要とする高速な行列の乗算を行う枠組みを用いて、スパースな埋め込み表現に対してK-meansクラスタリングを行う手法を提案している。また本研究ではRPの近似精度についても改善を行っている。ILSVRC2012等のデータセットに対して従来の次元削減手法を次元を落としてからK-meansクラスタリングをした結果と、提案手法の高速な次元圧縮を利用したクラスタリング結果を比較している。

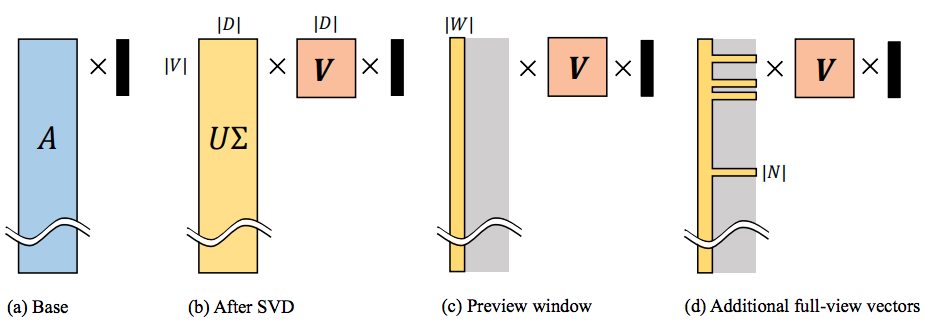

SVD-Softmax: Fast Softmax Approximation on Large Vocabulary Neural Networks

- Kyuhong Shim, Minjae Lee, Iksoo Choi, Yoonho Boo, Wonyong Sung (Poster)

本研究では特異値分解を利用した、とても大きいボキャブラリを持つSoftmax関数を高速に近似する手法を提案している。SVD-Softmaxはニューラル言語モデルの推論時に最上位となりうる単語について、高速かつ正確に確率推定を行うことを目的としている。提案手法ではSVDを使って出力ベクトルの計算に用いた重み行列を変換する。各単語の近似確率については、いくつかの大きな特異値を使用することで単語の大部分の性質を持たせることができ、これを利用して重み行列を推定できると主張している。

本研究の手法を言語モデリングとニューラル機械翻訳に適用することで、提案手法で導入されている近似手法が効果を発揮していることを検証している。本アルゴリズムでは800,000個の語彙の場合においても、約20%程度の算術演算しか必要とせず、GPUを利用することで3倍以上スピードアップしていることが分かっている。

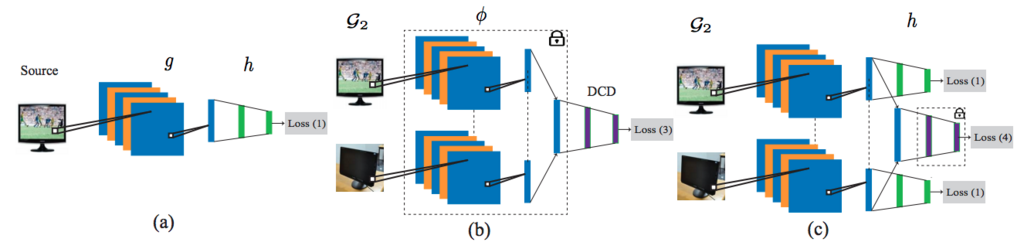

Few-Shot Adversarial Domain Adaptation

- Eleni Triantafillou, Richard Zemel, Raquel Urtasun (Poster)

本研究ではDeepモデルを用いた教師ありのドメイン適応の問題に対して対処するフレームワークを提案している。主なアイディアは埋め込み表現を学習する際にAdversarialな学習を導入し、2つの異なるドメインの特徴を保持するように埋め込みつつ、同時に埋め込み表現が意味をなすように配置させるところである。教師ありタスクの場合、一般的には大量のラベル付与済みデータが必要であるが、ラベルを付与すべきデータが少なく済むことでより扱いやすい問題となる。こういったFew-shotな学習の場合にデータ欠損があると、埋め込み空間に対して埋め込み表現の配置と分離というのは困難を極める。

提案モデルでは典型的な2値のAdversarial discriminatorが4つの異なるクラスを分離するためにData augmentationに工夫することで、教師ありのドメイン適応問題対して有効であることを見つけている。加えて本手法ではラベル付与済みデータがとても少ない場合、特にカテゴリあたり1サンプルであったとしても高速に適応できていることが示されている。MNISTやSVHNデータセット等を用いて本手法のドメイン適応の効果を確認している。

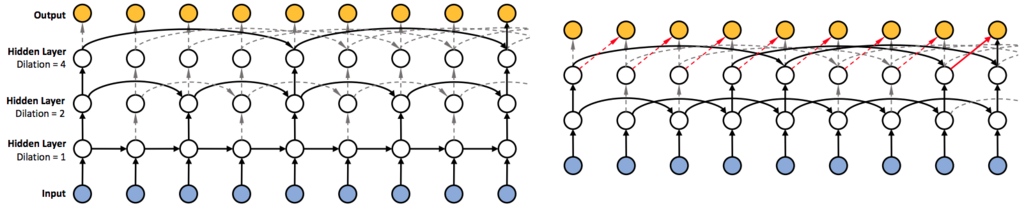

Dilated Recurrent Neural Networks

- Shiyu Chang, Yang Zhang, Wei Han, Mo Yu, Xiaoxiao Guo, Wei Tan, Xiaodong Cui, Michael Witbrock, Mark A. Hasegawa-Johnson, Thomas S. Huang (Poster)

長い文章等に対してRNNを学習させることはとても難しい問題となっている。特に複雑な依存関係、勾配消失/爆発問題、並列化が難しい点が挙げられている。本研究ではシンプルで効率的なRNNのアーキテクチャであるDilatedRNNを提案している。本アーキテクチャは複数のDilated recurrent skip connectionを組み合わせており、さまざまなRNNセルとフレキシブルに組み合わせることができる。またDilatedRNNは必要なパラメータ数を減らしつつ学習効率を大幅に向上させることができ、とても長いスパンで依存性のあるデータやタスクで優れたパフォーマンスを発揮している。

提案モデルの利点を理論的に定量化するため、Memory capacity measureを導入している。これは長いスキップコネクションを持つRNNに対して既存の指標よりも適していることが示されており、LSTMなど他のRNNアーキテクチャのMemory capacity measureを比較することでDilatedRNNが優れていること証明している。

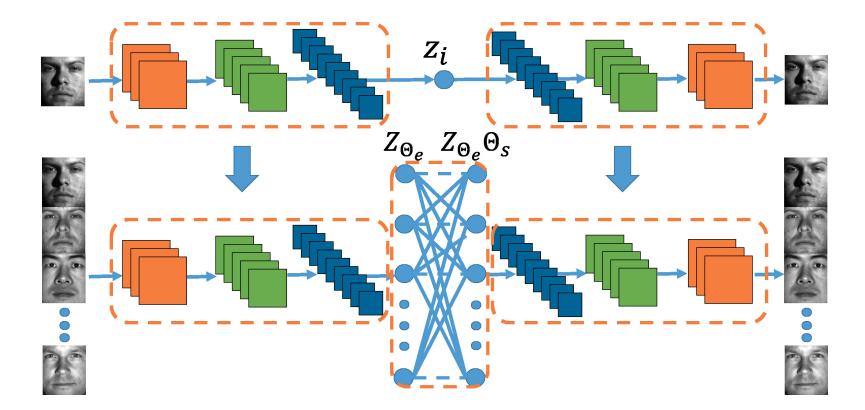

Deep Subspace Clustering Networks

- Pan Ji, Tong Zhang, Hongdong Li, Mathieu Salzmann, Ian Reid (Poster)

本研究では教師なしサブスペースクラスタリングのためのDeep neural networkアーキテクチャを提案している。本アーキテクチャは入力データを潜在空間に非線形で写像するDeep auto-encoderをベースとしている。本研究での重要なポイントとして、従来のサブスペースクラスタリングで効果的であると証明されている「Self-expressiveness」という特性を模倣するため、EncoderとDecoderとの間に新しくSelf expressiveレイヤーを導入している点が挙げられる。

本研究で導入されたSelf expressiveレイヤーは、一般的なBackpropagationを通じてすべてのデータ点間の類似性をシンプルかつ効果的に学習するものとなっている。またこのレイヤーは非線形であるため、本研究のアーキテクチャは複雑な構造を持つデータ点を容易にクラスタリングできる。加えて、Subspace clutering networkのパラメータを効率的に学習させるためのPre-trainingとFine-tuningを提案している。Subspace clustering networkが先行研究の教師なしサブスペースクラスタリング手法よりも遥かに優れていることを示している。

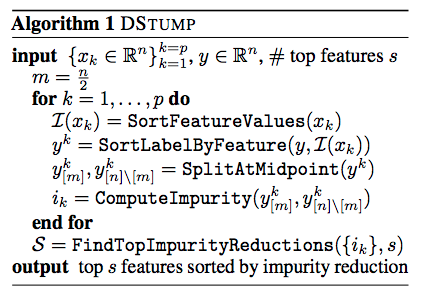

Variable Importance Using Decision Trees

- Jalil Kazemitabar, Arash Amini, Adam Bloniarz, Ameet S. Talwalkar (Poster)

決定木とランダムフォレストは優れたパフォーマンスと示すだけでなく、Feature importanceといった情報が分かる、確立されたモデルである。 不純度ベースで変数の重要度を知ることができるため使われることが多いモデルであるが、これらの重要度は理論的に不明な点が多い。

本研究ではDSTUMPを提案し、様々な仮定におけるモデリングの下で高次元のデータ利用で有限のサンプルパフォーマンス保証性を導き出すことによって、ツリー系のモデルの性能についての考察を行っている。またこれら不純度ベースの手法の有効性について、広範囲の実験を下に有効性を実証している。

Deanonymization in the Bitcoin P2P Network

- Giulia Fanti, Pramod Viswanath (Poster)

ビットコインにおけるP2Pネットワークに対する近年の攻撃では、ネットワーク一貫性を確保するために使用されるTransaction-floodingプロトコルを悪用することによって、ユーザの匿名性を奪うことがが可能となってしまっていた。2015年にビットコインコミュニティでは、このプロトコルをDiffusionと呼ばれるプロトコルに変更することで、こうした攻撃に対応した。

しかしながらこのDiffusionプロトコルが実際にシステムに対して匿名性を向上させるかどうかは明確には分かっていない。本論文ではビットコインのネットワークをモデル化し、2015年前後の匿名性について分析を行っている。中心となる問題はグラフ上での流行源の推論/特定の1つとなっている。観測モデルと拡散メカニズムについてはビットコインの実装から分かるが、注目すべきはこうしたモデルは先行研究で研究されていない点である。本研究では最適な流行源推定量を特定し、分析する内容となっている。

分析結果として、2015年前後のビットコインネットワークプロトコルは通常のネットワーク上で脆弱な匿名性を提供していたことが判明している。実際に2015年のビットコインP2Pネットワークのスナップショットでシュミレーションを行い、本研究での主張を確認している。

Unsupervised Learning of Disentangled and Interpretable Representations from Sequential Data

- Wei-Ning Hsu, Yu Zhang, James Glass (Poster)

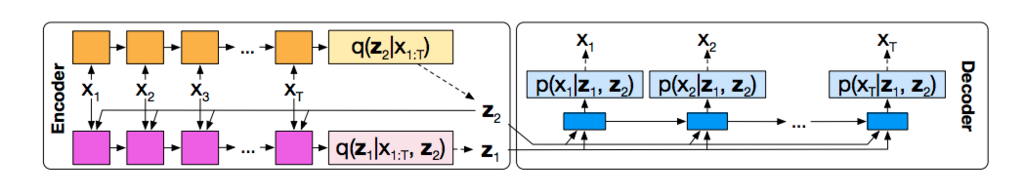

本研究では教師なしの連続データに対して解釈可能な表現を学習するFactrized hierarchical variational autoencoderを提案している。具体的には潜在変数のことなるデータに対し、事前確率としてSequence-dependent priorsとSequence-independent priorsをFactorized hierarchical graphical model内で組み合わせることで、連続データが持つマルチスケールな情報を利用するモデルとなっている。

本モデルは2つの音声コーパスTIMITとAurora-4を用いて評価を行っている。具体的には異なる潜在変数の組を使って、スピーカーや言語コンテンツを変換する能力を定性的に評価している。

まとめ

NIPS2017の論文について概要を見ていきました。この他にも多数の論文がAcceptされています。同じく機械学習のトップカンファレンスであるICMLと、今回のNIPSでAcceptされた論文の総数が1113本あるようです。*1

この他にも私自身が読んだ論文を以下のレポジトリでまとめていたりします。よろしければスター等つけていただけると励みになります。

年末までに1日40本程度読めばすべて読めるらしいので、ぜひ読破して教えていただきたいです!